Azure OpenAI Service新增Prompt Caching功能

Category :

News

Prompt Caching點樣幫開發者慳成本?

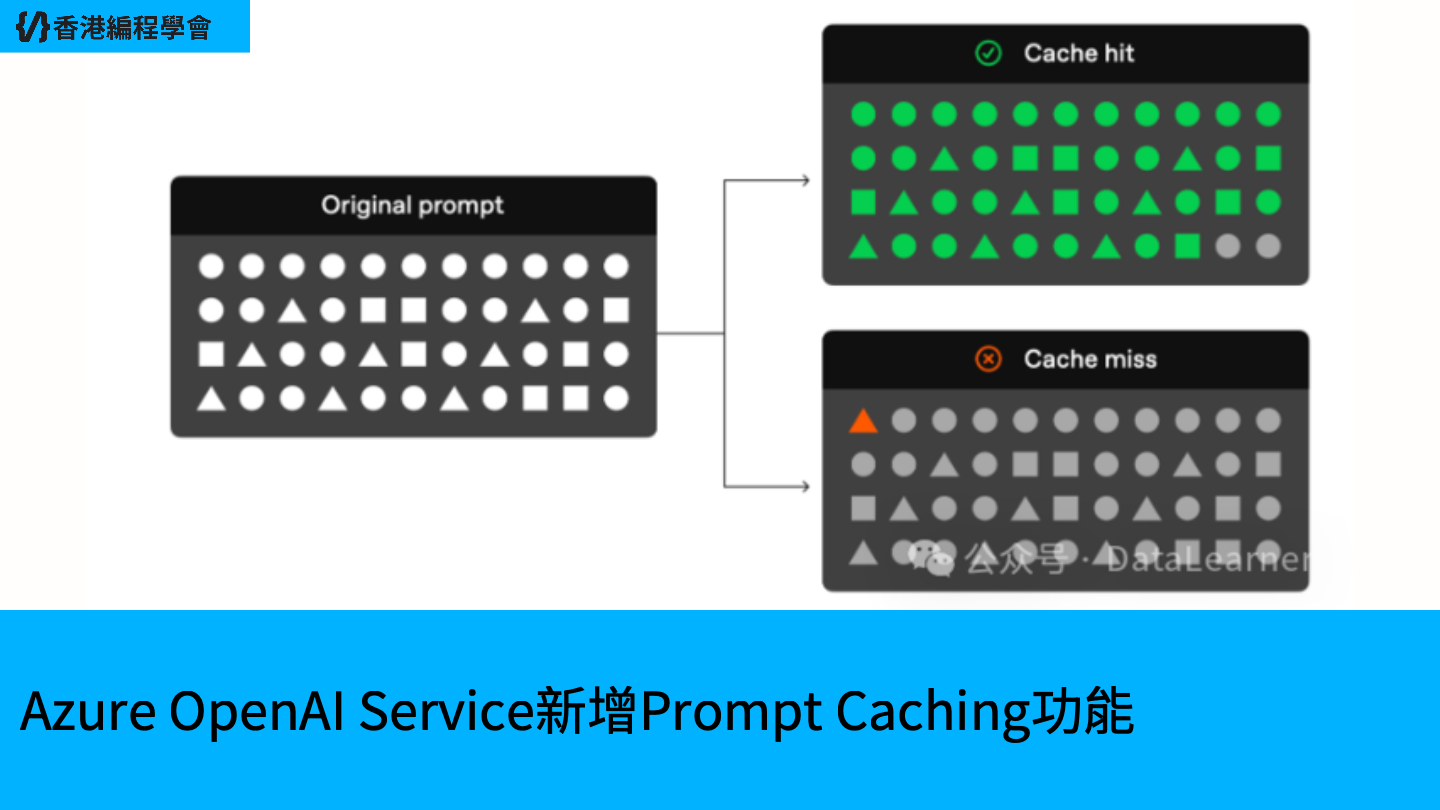

Azure OpenAI Service喺2024年11月7日宣佈推出Prompt Caching功能,支援o1-preview、o1-mini、GPT-4o同GPT-4o-mini模型。呢個功能可以重用最近見過嘅輸入標記(Tokens),大幅降低開發者嘅成本同延遲。喺香港嘅應用場景,例如聊天機械人同代碼編輯應用,Prompt Caching可以幫企業節省高達50%嘅運算成本,同時加快回應速度。

喺技術層面,Prompt Caching利用咗Azure嘅高效基礎設施,自動識別同儲存重複出現嘅上下文數據。舉個例,一間香港嘅電子商務公司用Azure OpenAI Service去開發客戶服務機械人,呢個功能可以記住常見嘅客戶查詢,例如產品規格或者退貨政策,減少每次查詢嘅運算需求。根據X上@Azure嘅帖子(2025年5月20日),呢個功能特別適合需要頻繁使用相同上下文嘅應用場景,例如長篇對話或者代碼自動補全。

喺香港嘅市場,成本控制同快速回應係企業競爭嘅關鍵。Prompt Caching唔單止幫開發者慳錢,仲提升咗用戶體驗,因為AI回應時間大幅縮短。Microsoft仲提到,呢個功能同Azure嘅數據駐留(Data Residency)解決方案結合,確保企業符合本地數據保護法規。想了解更多,可以去呢度查閱。